Durante el todo el libro cito diversas investigaciones que han intentado estimar por uno u otro método la presencia de las malas prácticas en la ciencia, aunque como comento en el libro, medir comportamientos que tienen connotaciones morales —que pueden ser mal vistos socialmente— es complicado. El capítulo D de la actual edición («Mala conducta científica: ¿leyenda urbana o realidad?») es el profundiza en esta cuestión.

Tener un resumen de una cara siempre es útil. Por eso he pensado usar esta página como listado de investigaciones en el ámbito de la ciencia descuidada y la mala ciencia. Ahora pongo algunas de las fuentes que he incluido en el ensayo pero lo iré actualizando conforme vaya encontrando más investigaciones.

The Prevalence of Inappropriate Image Duplication in Biomedical Research Publications (Bik et al., 2016)

[Extraído del libro…] En 2016 Bik y otros colegas publicaron la investigación en la que habían analizado más de 20 000 artículos académicos publicados entre 1995 y 2014 en 40 revistas diferentes, encontrando que casi el 4 % (unos 800) contenían imágenes manipuladas. Tras este sorprendente hallazgo Bik decidió contactar con las revistas implicadas, pero solamente un tercio de ellas dieron alguna respuesta al cabo de dos años.

Artículo en: https://doi.org/10.1128/mBio.00809-16

False-Positive Psychology: Undisclosed Flexibility in Data Collection and Analysis Allows Presenting Anything as Significant (Simmons et al., 2011)

[Extraído del libro…] En 2011 Simmons y sus colega publicaron en Psychological Science un petrificante estudio en el que mostraban qué fácil resulta para los investigadores obtener datos significativos a partir de muestras sin efectos aparentes, con el sencillo uso de diferentes técnicas cuestionables de investigación, tales como explorar múltiples variables dependientes o covariables informándolas solamente cuando los resultados resultan significativos.

Artículo en: https://doi.org/10.1177/0956797611417632

Cheating in Science (St James-Roberts, 1976)

[Extraído del libro…] Aunque podamos pensar que la preocupación por las malas prácticas es algo actual, no es así. Durante la fase de documentación encontré un artículo de revista científica fechado en 1976, titulado Cheating in Science, de Ian St James-Roberts, en el que presentaban los resultados que habían obtenido de la encuesta realizada a los lectores de la revista New Scientist, quienes recibieron unos cuestionarios para ser devueltos tras ser cumplimentados. El autor advierte de las deficiencias metodológicas de la investigación, llena de puntos débiles, pero pensó que era interesante publicar los datos obtenidos como primera cata sobre la problemática y por deferencia a los lectores que se habían molestado en contestar. En la encuesta se preguntaba sobre los sesgos intencionales en investigación** . El 99 % de los que respondieron habían tenido conocimiento de algún sesgo intencional en su campo y el 66 % conocía más de un caso. Los tipos de malas prácticas más frecuentemente reportadas fueron: masaje de datos (74 %); manipulación inadecuada de los experimentos (17 %); fabricación completa de los experimentos (17 %) e interpretación deliberadamente errónea de los resultados (2 %).

Artículo: St James-Roberts, I. (1976). Cheating in science. New Scientist, 72(1028), 466-469.

Scientists behaving badly (Martinson et al., 2005)

[Extraído del libro…] Atendiendo a las respuestas de los participantes, existe un grupo de comportamientos, seis de los dieciséis (entre ellos falsificación y plagio), cuya frecuencia está por debajo del 2 % —es decir, menos del 2 % de la muestra confesó haber estado involucrado en esos comportamientos en alguna ocasión durante los últimos tres años, un porcentaje consistente con la estimación que se manejaba en otros estudios. Sin embargo, hasta nueve malas prácticas fueron admitidas por encima del 5 % de los encuestados. Las prácticas más reconocidas fueron las siguientes:

- 27,5 %: Mantener registros inadecuados relacionados con los proyectos de investigación.

- 15,5 %: Cambiar el diseño, la metodología o los resultados de un estudio como respuesta a la presión de una fuente de financiación.

- 15,3 %: Eliminar observaciones o puntos de datos de los análisis basados en la intuición de que eran inexactos.

- 13,5 %: Usar diseños de investigación inadecuados o inapropiados.

- 12,5 %: Pasar por alto el uso de datos cuestionables o de interpretaciones cuestionables que otros hacen.

- 10,8 %: Retener detalles de la metodología o los resultados en artículos o propuestas.

- 10,0 %: Asignar inapropiadamente los créditos de autoría.

En conjunto, el 33 % de los encuestados admitió haber estado involucrado en al menos una práctica cuestionable en los últimos tres años.

Artículo en: https://www.nature.com/articles/435737a

Fostering integrity in research: Definitions, current knowledge, and future directions (Steneck, 2006)

[Extraído del libro…] En 2006 Steneck publicó un artículo peer reviewed donde hacía una revisión del estado de la problemática en aquel momento, que considero ideal como segunda aproximación para intentar ponderar la magnitud de las malas prácticas en investigación.

En su revisión, Steneck presenta multitud de estudios que intentaron hasta aquella fecha medir la presencia de las malas prácticas en el entorno de investigación*.

Los primeros datos hacen referencia al número de investigaciones resueltas por la ORI (y otras agencias gubernamentales) donde los investigados resultaron culpables. Aproximadamente entre 1995 y 2005, la media estuvo entre 20 y 30 casos por año; considerando la base de unos dos millones y medio de investigadores, obtendríamos una tasa del 0,001% de investigadores fraudulentos. No obstante, otras métricas estiman esta cifra en el 0,01 %, aunque ambas parecen estar muy lejos de la realidad, ya que otros trabajos (citados en el artículo de Steneck) han puesto de manifiesto que los investigadores, a pesar de conocer las malas prácticas suyas y de otros, habitualmente no las denuncian. Como Steneck afirma «el argumento de que la mala conducta en la investigación es “poco frecuente” no está respaldado por pruebas sólidas».

Artículo: https://doi.org/10.1007/PL00022268

How Many Scientists Fabricate and Falsify Research? A Systematic Review and Meta-Analysis of Survey Data (Fanelli, 2009)

[Extraído del libro…] Debido a que vamos a encontrar muy a menudo los datos de este artículo citados de forma escueta, creo que resultaría interesante desgranar un poco la metodología utilizada, para ir más allá del titular o las conclusiones que habitualmente citan muchos, con el fin de entender qué se esconde detrás de la cifra. Veamos:

- Para comenzar con la selección de publicaciones a considerar en el metaanálisis se realizó en varios idiomas una búsqueda de artículos que incluyeran palabras clave relacionadas con la mala conducta en investigación (research misconduct, research integrity, fabrication…).

- De las 3276 referencias obtenidas inicialmente, para el metaanálisis fueron seleccionados 21 artículos.

- La fecha de publicación de los estudios seleccionados estaba comprendida entre 1988 y 2005.

- La investigación se centró en aquellos comportamientos que pueden falsificar o sesgar el conocimiento científico, tales como la fabricación de datos, la no publicación intencional de resultados, la falsificación…, dejando aparte otras prácticas, que aunque son consideradas como QRPs, como el plagio o el mal comportamiento profesional, no dañan propiamente el conocimiento.

Los resultados obtenidos fueron los siguientes:

- De media, un 1,97 % de científicos admite haber fabricado, falsificado o modificado datos o resultados al menos una vez.

- Un 33,7 % admite haber realizado alguna vez otras prácticas tales como «borrar puntos de los datos basados en un sentimiento visceral» o «cambiar el diseño, la metodología o los resultados del estudio como respuesta a la presión de la fuente de financiación».

- Si lo que se pregunta es sobre el comportamiento de otros compañeros —no de uno mismo— es el 14 % el que indica que estas prácticas (fabricación de datos, falsificación o modificación) han sido cometidas por otros. En cuanto a las otras prácticas menos graves, el 72 % contesta que otros compañeros sí las han realizado.

Artículo en: https://doi.org/10.1371/journal.pone.0005738

Measuring the Prevalence of Questionable Research Practices With Incentives for Truth Telling (John et al., 2012)

[Extraído del libro…] Leslie K. John, del Departamento de Marketing de la Harvard Business School, George Loewenstein, de la Carnegie Mellon University, y Drazen Prelec, afiliado a la Sloan School of Management y al MIT, publicaron en 2012 un paper en el que encuestaron a más de 2000 psicólogos para tratar de medir su implicación en malas prácticas de investigación (QRPs)*. Además, midieron el efecto de un incentivo por decir la verdad (se harían donaciones a organizaciones de caridad en función de «cuánto de verdad» fuese la respuesta), con el que, combinándolo con otras variables, trataban de neutralizar la dificultad de ponderar exactamente en autocuestionarios** la presencia de un comportamiento cuando este puede tener connotaciones de inmoralidad —en la sección anterior anticipamos ya esta problemática.

¡Atención, spoiler! : es inquietante comprobar que para algunas QRPs consideradas casi el 100 % de los participantes admitió haberlas realizado alguna vez.

[…] Considerando los datos de aquellos que fueron incentivados para decir la verdad, y considerando solamente las respuestas a los ítems que evaluaban a uno mismo (self-admissión rate), quitando el ítem de falsificación —para poderlo comparar con los datos del estudio de Fanelly de años atrás— obtenemos que el 36,6 % de los participantes admitió haber participado alguna vez en comportamientos cuestionables de investigación; en la condición de control (donde no se les ofrecía el incentivo por decir la verdad), la media bajaba al 33,3 % (este dato sí, similar al obtenido en el metaanálisis de Fanelly en 2009). Además, entre los participantes que completaron la encuesta en la condición con incentivo para decir la verdad, el 94 % admitió haber estado implicado al menos una vez en alguna mala práctica.

Artículo en: https://doi.org/10.1177/0956797611430953

Editorial: Evidence on Questionable Research Practices: The Good, the Bad, and the Ugly (Banks et. al, 2016)

[Extraído del libro…] Con un análisis de 64 estudios, esta publicación cumple perfectamente con el objetivo que nos planteamos al inicio de esta sección, responder a la pregunta «¿son las malas prácticas en investigación realmente un problema?». El artículo está rebosante de referencias a estudios que han intentado responder a esta pregunta por uno u otro método, así que recomiendo su consulta a aquellos lectores más interesados** .

Tan solo voy a listar aquí las principales observaciones que encontraron (traduzco literalmente del inglés algunas de ellas):

- De los 64 estudios analizados, 58 (91 %) indicaban que habían encontrado una evidencia severa de QRPs en sus hallazgos (es decir, que realmente las malas prácticas existen en la industria de la ciencia).

- Las QRPs más comunes fueron las de HARKing*** y la de reportar selectivamente los resultados, con preferencia por aquellos que son estadísticamente significativos.

- Las tasas de presencia de QRPs actuales están probablemente subestimadas.

- Los estudios basados en las observaciones de las QRPs generalmente ilustran tasas más altas que los basados en autoinformes. Los estudios no basados en autoinformes, tales como los de observación del comportamiento o análisis sensitivos, también proveen una consistente evidencia de la implicación de los investigadores en malas prácticas de investigación.

- Los editores y los revisores parecen jugar un papel importante en la incidencia de las QRPs.

- La implicación en las QRPs no parece variar según el rango académico del investigador.

- La inmensa mayoría de investigación en QRPs se ha centrado principalmente en prácticas que afectan a los p-values, por lo que sería necesaria más investigación de otro tipo.

Artículo en: https://doi.org/10.1007/s10869-016-9456-7

Data fabrication and other reasons for non-random sampling in 5087 randomised, controlled trials in anaesthetic and general medical journals (Carlisle, 2017)

[Extraído del libro…] En 2017 Carlisle publicó en la revista Anaesthesia un trabajo en el que había incluido 5087 artículos fechados entre el 2000 y el 2005, publicados en ocho revistas diferentes. Para realizar el trabajo analizó la distribución de más de 70 000 medias de casi 30 000 variables —ahora comprenderéis por qué asocio estas técnicas al big data, ¿verdad? 🙂 .

Entre otros hallazgos, el estudio encontró que al menos el 2 % de los estudios analizados contenían datos falsos o fraudulentos. El descubrimiento fue tan sorprendente, y el método tan fácil de implementar (en estudios puntuales), que la propia revista Anaesthesia decidió incorporarlos en sus mecanismos de revisión desde entonces.

Artículo en: https://onlinelibrary.wiley.com/doi/abs/10.1111/anae.13938

The GRIM Test: A Simple Technique Detects Numerous Anomalies in the Reporting of Results in Psychology (Brown y Heathers, 2017)

[Extraído del libro…] Otro ejemplo de esta función de policía de asuntos internos lo encontramos en la labor de la curiosa pareja de investigadores Nick Brown y James Heathers. Quizá nos suene su nombre porque leímos sobre ellos en el reciente caso de Brian Wansink (Capítulo B, p. 109) y volveré a aludirlos en el apartado dedicado a los watchdogs del Capítulo E (p. 236). Brown y Heathers idearon un método (el GRIM) que evolucionaron poco después (el SPRITE), que permite hacer una especie de ingeniería inversa y calcular la probabilidad de que los datos de medias y desviaciones estándar reportados en un estudio provengan efectivamente de las muestras indicadas.

En 2016 publicaron un estudio en la revista Social Psychological and Personality Science en el que encontraron que 36 de los 260 artículos analizados contenían al menos un valor erróneo (lo que equivale al 13,8 %) y 16 más de uno —artículos todos ellos que habían pasado por un proceso de revisión por pares.

Artículo en: https://doi.org/10.1177/1948550616673876

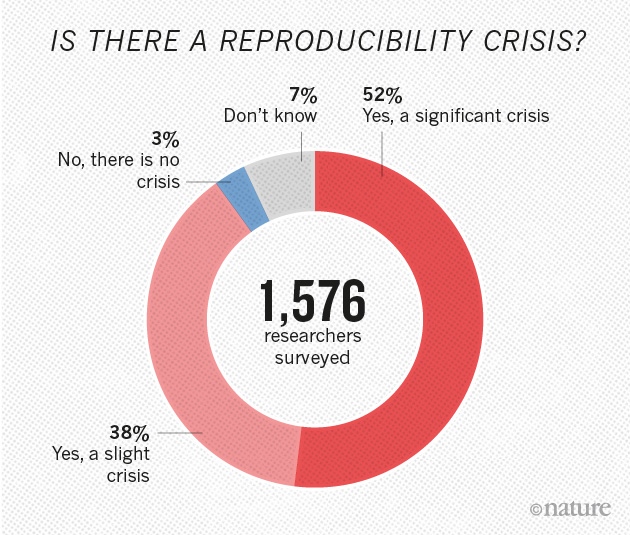

1,500 scientists lift the lid on reproducibility (Baker, 2016)

[Extraído del libro…] La revista Nature publicó en 2016 un estudio basado en encuestas en el que obtuvieron las respuestas de 1576 investigadores de diversas disciplinas. El cuestionario planteaba cuestiones sobre la experiencia con la replicación de experimentos (vemos parte de los resultados en la figura D.5). Más del 70 % afirmaron haber fallado alguna vez al intentar reproducir algún experimento; el 52 % opinaba que «hay una significativa crisis de reproducibilidad». Además, alrededor del 31 % creían que el hecho de fallar al intentar reproducir el resultado publicado significa que probablemente el resultado esté mal, pero la mayoría decía seguir confiando en la literatura.

Artículo en: http://www.nature.com/news/1-500-scientists-lift-the-lid-on-reproducibility-1.19970